En los últimos años Microsoft ha desarrollado sus sistemas de reconocimiento de imagen y audio. Si bien es cierto que no nos afecta ya que no se utiliza en productos de consumo el trabajo es increíble. El otro día hablábamos de su reconocimiento de audio y como había superado al oído humano y ahora han superado el ojo humano.

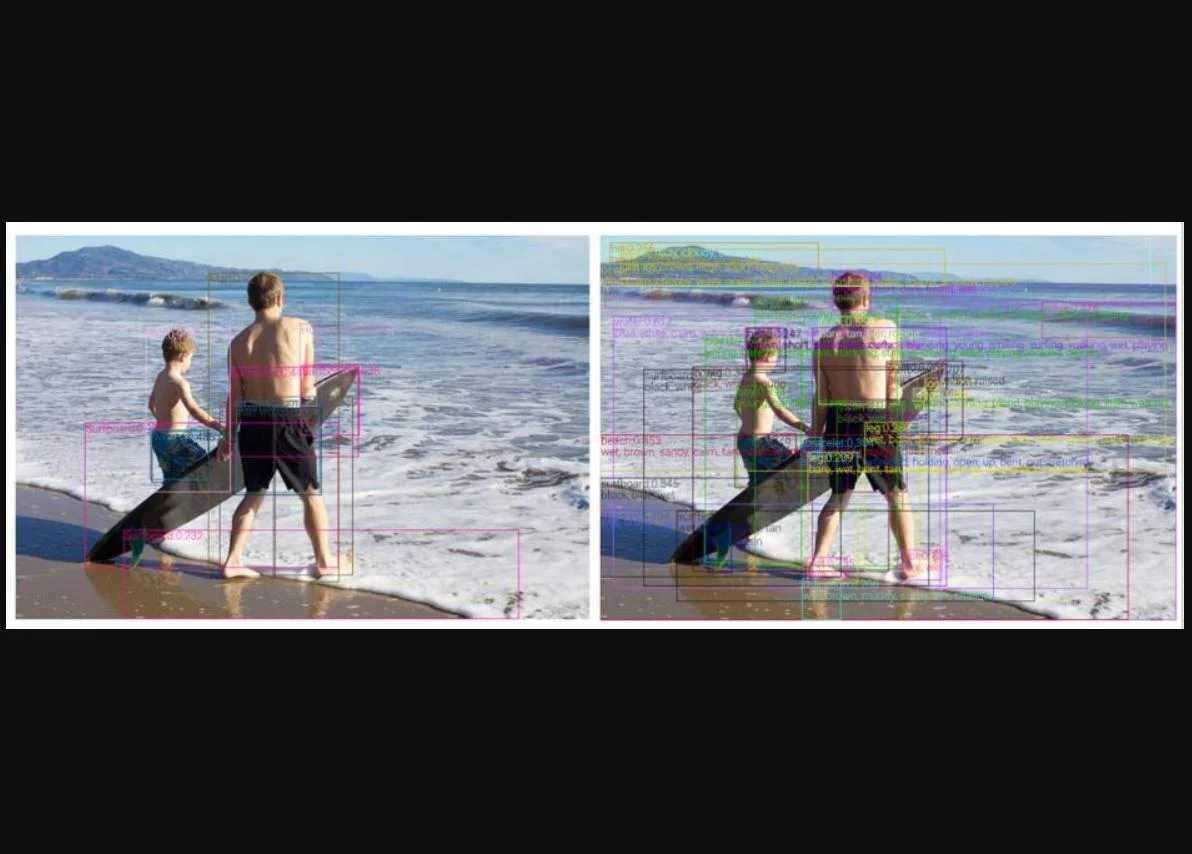

Los sistemas de lenguaje de visión (VL) permiten buscar en las imágenes relevantes una consulta de texto (o viceversa) y describir el contenido de una imagen utilizando lenguaje natural. En general, un sistema VL utiliza un módulo de codificación de imágenes y un módulo de fusión de lenguaje de visión. Microsoft Research ha desarrollado recientemente un nuevo modelo de detección de atributos de objetos para la codificación de imágenes denominado VinVL (Características visuales en Vision-Language).

El reconocimiento de objetos de Microsoft supera el ojo humano

El modo de conseguir este nuevo registro es mediante VinVL. Este se combina con módulos de fusión VL como OSCAR y VIVO. Gracias al cual el nuevo sistema VL de Microsoft fue capaz de alcanzar la primera posición en las tablas de clasificación VL más competitivas. Entre otros registros se incluyen Visual Question Answering (VQA), Microsoft COCO Image Captioning y Novel Object Captioning (nocaps). El equipo de Microsoft Research también destacó que este nuevo sistema VL supera significativamente el rendimiento humano en la tabla de clasificación de nocaps en términos de CIDEr (92,5 frente a 85,3).

VinVL ha demostrado un gran potencial en la mejora de la codificación de imágenes para la comprensión de VL. El modelo de codificación de imágenes puede beneficiar a una amplia gama de tareas de VL. A pesar de los resultados prometedores que han obtenido, el modelo no está alcanzando de ninguna manera la inteligencia a nivel humano de la comprensión de VL.

En Microsoft buscan ampliar aún más el preentrenamiento de la detección de atributos de objeto. Mediante el aprovechamiento de los datos masivos de clasificación/etiquetado de imágenes. Por otro lado, ampliando los métodos de representación VL cross-modal. Con el aprendizaje y la construcción de modelos de lenguaje basados en percepción que puedan poner a tierra conceptos visuales en el lenguaje natural y viceversa como lo hacen los humanos.

Microsoft VinVL se está integrando en Azure Cognitive Services, que impulsa varios servicios de Microsoft. El equipo de Microsoft Research también lanzará al público el modelo VinVL y el código fuente.