Hace un año, Microsoft presentó los modelos de lenguaje pequeños (SLMs) con el lanzamiento de Phi-3 en Azure AI Foundry, aprovechando la investigación en SLMs para ampliar la gama de modelos y herramientas de IA eficientes disponibles para los clientes. Ya os hemos hablado que estos modelos se encuentran dentro de Windows 11 y se actualizan cada mes.

Ahora se incorporan los siguientes modelos: Phi-4-reasoning, Phi-4-reasoning-plus y Phi-4-mini-reasoning, marcando una nueva era para los modelos de lenguaje pequeños y redefiniendo una vez más lo que es posible con IA pequeña y eficiente.

Phi-4 y sus próximos pasos

Los modelos de razonamiento están entrenados para aprovechar la escalabilidad en tiempo de inferencia para realizar tareas complejas que requieren descomposición en múltiples pasos y reflexión interna. Estos modelos sobresalen en el razonamiento matemático y están emergiendo como la columna vertebral de aplicaciones agenticas con tareas complejas y multifacéticas. Tales capacidades típicamente se encuentran solo en modelos de frontera grandes.

Los modelos de razonamiento Phi suponen una nueva categoría de modelos de lenguaje pequeños. Utilizando destilación, aprendizaje por refuerzo y datos de alta calidad, estos modelos equilibran tamaño y rendimiento. Son lo suficientemente pequeños para entornos de baja latencia, pero mantienen fuertes capacidades de razonamiento que rivalizan con modelos mucho más grandes. Esta combinación permite que incluso dispositivos con recursos limitados realicen tareas de razonamiento complejas de manera eficiente.

Phi-4-reasoning y Phi-4-reasoning-plus

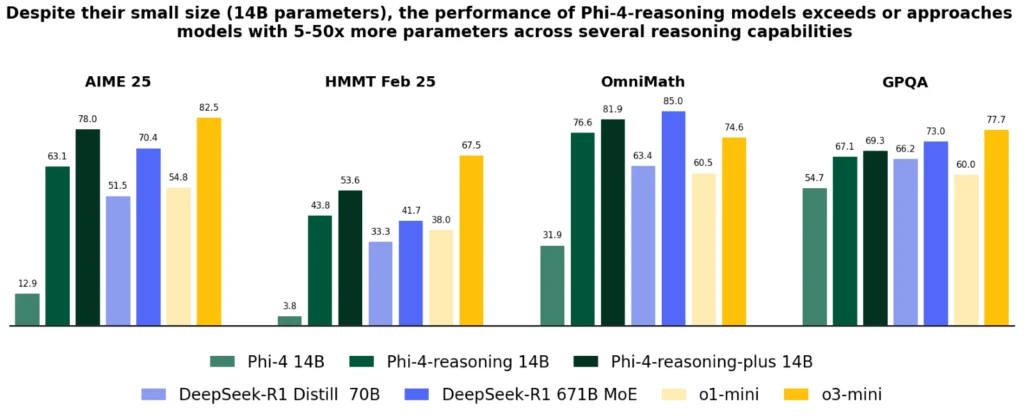

Phi-4-reasoning es un modelo de razonamiento de 14 mil millones de parámetros con pesos abiertos que rivaliza con modelos mucho más grandes en tareas de razonamiento complejas. Entrenado mediante ajuste fino supervisado de Phi-4 en demostraciones de razonamiento cuidadosamente seleccionadas de OpenAI o3-mini, Phi-4-reasoning genera cadenas de razonamiento detalladas que aprovechan eficazmente el cómputo adicional en tiempo de inferencia. El modelo demuestra que la meticulosa curación de datos y los conjuntos de datos sintéticos de alta calidad permiten que los modelos más pequeños compitan con sus contrapartes más grandes.

Phi-4-reasoning-plus se basa en las capacidades de Phi-4-reasoning, entrenado adicionalmente con aprendizaje por refuerzo para utilizar más cómputo en tiempo de inferencia, utilizando 1.5 veces más tokens que Phi-4-reasoning, para ofrecer mayor precisión.

A pesar de su tamaño significativamente menor, ambos modelos logran un mejor rendimiento que OpenAI o1-mini y DeepSeek-R1-Distill-Llama-70B en la mayoría de los benchmarks. Esto incluye razonamiento matemático y preguntas de nivel de doctorado en ciencias. Ambos modelos están disponibles en Azure AI Foundry y HuggingFace.

Phi-4-mini-reasoning

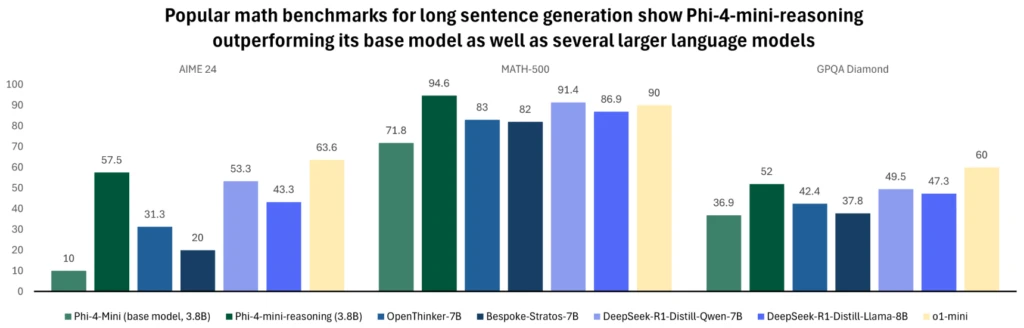

Phi-4-mini-reasoning está diseñado para satisfacer la demanda de un modelo de razonamiento compacto. Este modelo de lenguaje basado en transformadores está optimizado para el razonamiento matemático, proporcionando resolución de problemas de alta calidad y paso a paso en entornos con computación o latencia restringida. Ajustado con datos sintéticos generados por el modelo Deepseek-R1, Phi-4-mini-reasoning equilibra eficiencia con capacidad de razonamiento avanzada. Es ideal para aplicaciones educativas, tutoría integrada y despliegue ligero en sistemas de borde o móviles, y está entrenado en más de un millón de problemas matemáticos diversos que abarcan múltiples niveles de dificultad, desde la escuela secundaria hasta el nivel de doctorado.

La evolución de Phi en el último año ha empujado continuamente este límite de calidad frente a tamaño. Ha expandido la familia con nuevas características para abordar diversas necesidades. A lo largo de la escala de dispositivos Windows 11, estos modelos están disponibles para ejecutarse localmente en CPUs y GPUs. A medida que Windows trabaja para crear un nuevo tipo de PC, los modelos Phi se han convertido en una parte integral de los Copilot+PCs. En estos la variante Phi Silica está optimizada para NPU. Esta versión altamente eficiente y gestionada por el sistema operativo de Phi está diseñada para ser precargada en memoria. Se encuentra disponible con tiempos de respuesta rápidos y rendimiento eficiente en el consumo de energía. Esto permite invocarlo rápidamente con otras aplicaciones que se ejecutan en tu PC.

Mientras no usen estos modelos para la medicina o la ingeniería de poco valen. Ojalá hiciesen un proyecto conjunto de todas las IA para terminar con el cáncer, o para construir edificios seguros, o para cultivar alimentos y eliminar el hambre en el mundo. Sería mucho mejor que andar haciendo memes con el Copilot.

Mira el artículo que hice sobre el uso de la IA para baterías. Han eliminado miles de combinaciones y quedan 100 o así para evolucionar las baterías

Gracias por recordarme el artículo. Interesante desde luego. Ya no me acordaba.

https://microsofters.com/microsoft/microsoft-y-la-ia-descubren-un-nuevo-material-para-baterias-mas-seguras-y-eficientes/