El gigante de Redmond sigue trabajando en nuevos modelos y ahora ha presentado Phi-4-mini-flash-reasoning, su último avance en modelos de IA orientados al razonamiento. Este modelo está diseñado para entornos con restricciones de cómputo, memoria y latencia, como dispositivos móviles o aplicaciones como Edge.

Phi-4-mini-flash-reasoning usos del nuevo modelo

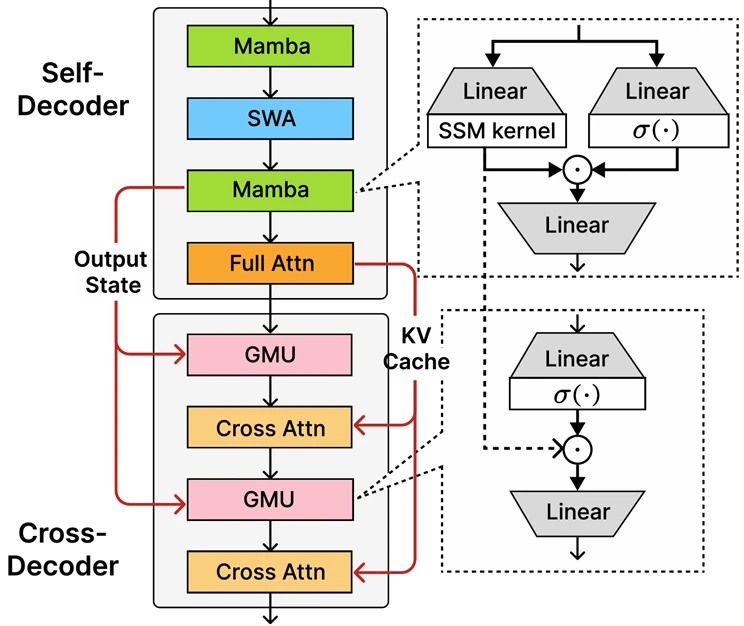

Se trata de una evolución del modelo Phi-4-mini, ahora con una arquitectura completamente nueva, SambaY, que utiliza lo que Microsoft ha denominado Gated Memory Units (GMUs). Estas unidades permiten compartir representaciones entre capas de manera más eficiente, lo que se traduce en hasta 10 veces más rendimiento y una reducción del 60% de la latencia promedio.

En términos simples, el modelo puede razonar y responder con gran rapidez, incluso en tareas complejas que requieren cálculos matemáticos, lógica estructurada o comprensión de contextos largos, gracias a su capacidad de manejar hasta 64.000 tokens de contexto.

Además, su estructura híbrida incorpora una combinación de State Space Models (Mamba) y Sliding Window Attention (SWA), junto con capas de atención completa. Este enfoque permite mantener la eficiencia sin comprometer la capacidad de razonamiento.

Según Weizhu Chen, Vicepresidente Corporativo en IA Generativa de Microsoft, este modelo está enfocado en proporcionar soluciones reales donde la eficiencia y la flexibilidad son clave: desde asistentes de estudio móviles hasta sistemas educativos adaptativos que ajustan el contenido en tiempo real.

El modelo se puede probar ya en Azure AI Foundry, Hugging Face y el catálogo de API de NVIDIA, lo que abre la puerta a un sinfín de aplicaciones empresariales y educativas.

Phi-4-mini-flash-reasoning ha sido entrenado siguiendo los principios de IA responsable de Microsoft, utilizando técnicas como Supervised Fine-Tuning, Reinforcement Learning con feedback humano, y Direct Preference Optimization, para garantizar seguridad y minimizar respuestas nocivas.